Föreläsning 3

description

Transcript of Föreläsning 3

Föreläsning 3

732G05

Regressions- och tidsserieanalys

2

En påbyggnad på enkel linjär regression

Beskriva en beroende variabel y utifrån k stycken förklarande variabler x1, x2, …, xk

Multipel linjär regression

kk xxxy 22110

Där ε är feltermen (error term), som står för den del av variationen i y som inte kan förklaras av modellen. Feltermen antas:

Ha medelvärde 0

Ha konstant varians σ2

Vara normalfördelad

Vara oberoende av andra ε

3

Multipel linjär regressionKvadratsummor och varians Samma beräkningar för SST och SSR

Kvadratsummeuppdelning SST = SSR + SSE gäller fortfarande

SSE beräknas på samma sätt som innan:

n

ikikiii xbxbxbbySSE

1

222110

iy

Variansen (σ2) skattas med MSE: )1(2

kn

SSEs

Standardavvikelsen (σ) skattas med: s2

4

Multipel linjär regressionHur utreda om modellen är bra?1. F-test (Overall F-test, testar hela modellen)

• H0: Alla parametrar (β1, β2,…, βk) är lika med noll

• Ha: Minst en av parametrarna är skild från noll

MSE

MSR

knSSE

kSSRF

1

• Där k är antalet parametrar i modellen

• Detta värde jämförs med Fα med k och n-k-1 frihetsgrader

2. T-test (testar varje enskild variabel)

• Beräknas på samma sätt som i enkel linjär regression

• Skillnad är att t-fördelning med n-k-1 frihetsgrader används

5

Multipel linjär regressionHur utreda om modellen är bra?

3. Förklaringsgrad (R2)

Beräknas och tolkas på samma sätt som i enkel linjär regression

4. Justerad förklaringsgrad ( )

R2 ökar alltid när en ny förklarande variabel läggs till i modellen

Den justerade förklaringsgraden tar hänsyn till antalet förklarande variabler

Denna ska användas vid jämförelse av modeller med olika antal förklarande variabler

R2

)1(

1

122

kn

n

n

kRR

6

Multipel linjär regressionExempel 1 Ett datamaterial bestående av 150 slumpmässigt valda

husförsäljningar i USA

Name Antal Beskrivning ModellPrice 150 Pris yArea 150 Area i kvadratfot x1Acres 150 Tomtyta i tunnland x2Rooms 150 Antal rum x3Baths 150 Antal badrum x4

Vi vill undersöka hur priset beror på de förklarande variablerna

7

Multipel linjär regressionExempel 1

350025001500500

300000

200000

100000

Area

Price

Pris mot bostadsyta

8

Multipel linjär regressionExempel 1

20100

300000

200000

100000

Acres

Price

Pris mot tomtyta

9

Multipel linjär regressionExempel 1

1383

300000

200000

100000

Rooms

Price

Pris mot antal rum

10

Multipel linjär regressionExempel 1

4321

300000

200000

100000

Baths

Pri

ce

Pris mot antal badrum

11

Multipel linjär regressionExempel 1 Minitab: Stat → Regression → Regression

12

Multipel linjär regressionExempel 1Regression Analysis: Price versus Area; Rooms

The regression equation is

Price = 64221 + 49,7 Area - 141 Rooms

Predictor Coef SE Coef T P

Constant 64221 12766 5,03 0,000

Area 49,673 7,507 6,62 0,000

Rooms -141 2934 -0,05 0,962

S = 30047,0 R-Sq = 48,6% R-Sq(adj) = 47,9%

Analysis of Variance

Source DF SS MS F P

Regression 2 1,25273E+11 62636682991 69,38 0,000

Residual Error 147 1,32715E+11 902824574

Total 149 2,57989E+11

13

Multipel linjär regressionPunktskattningar En vanlig tillämpning av multipel linjär regression är att man vill

skatta (prediktera) värden för nya observationer

Punktskattning (punktprediktion beräknas på samma sätt):

kk xbxbxbby 22110ˆ

Punktskattning (point estimate):

Det skattade medelvärdet på y för alla observationer med de givna värdena på x

Punktprediktion (point prediction):

Värdet en individuell observation väntas ha på y med de givna värdena på x

14

Multipel linjär regressionIntervallskattningar Konfidensintervall (hör till punktskattning)

Ett intervall för medelvärdet på y med de givna värdena på x

value"Distance"ˆ )1(2/0 sty kn

Prediktionsintervall (hör till punktprediktion)

Ett intervall för värdet på y för en individuell observation med de givna värdena på x

value"Distance"1ˆ )1(2/0 sty kn

”Distance value” fås från datorutskrift

Minitab: SE Fit = value"Distance"s

15

Multipel linjär regressionExempel punktskattningar och intervallskattningar Ett intervall för hus med area 3000 kvadratfot och 6 rum

Minitab: Stat → Regression → Regression → Options

16

Multipel linjär regressionExempel punktskattningar och intervallskattningar

Predicted Values for New Observations

New

Obs Fit SE Fit 95% CI 95% PI

1 212396 12307 (188076; 236717) (148229; 276564)XX

XX denotes a point that is an extreme outlier in the predictors.

17

Multipel linjär regressionExempel punktskattningar och intervallskattningarPredicted Values for New Observations

New

Obs Fit SE Fit 95% CI 95% PI

1 212396 12307 (188076; 236717) (148229; 276564)XX

XX denotes a point that is an extreme outlier in the predictors.

Minitab indikerar att vår prediktion inte är helt pålitlig

Vad kan detta bero på?

18

Multipel linjär regressionExempel punktskattningar och intervallskattningar

350025001500500

300000

200000

100000

Area

Pri

ce

1383

300000

200000

100000

Rooms

Pri

ce

19

Multipel linjär regressionExempel 117000 1008 6

108000 1036 6

126500 1092 6

133000 1100 6

116000 1100 6

98000 1165 6

129000 1200 6

126000 1232 6

117000 1248 6

110000 1289 6

117500 1300 6

121900 1300 6

100000 1338 6

128500 1344 6

135000 1400 6

140000 1403 6

152000 1450 6

110000 1450 6

142500 1552 6

150000 1564 6

120500 1600 6

141900 1632 6

145900 1680 6

144900 1900 6

Pris Area Rum

Kombination 3000 kvadratfot och 6 rum finns ej i datamaterialet

Är vår modell giltig för den prediktion vi ville genomföra?

20

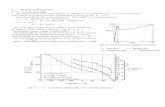

Multipel linjär regressionKvadratiska och kubiska termer

Det kan vara ett annat samband än linjärt mellan den beroende variabeln och en förklarande variabel

Då kan man inkludera en kvadratisk eller kubisk term i regressionsmodellen

Antal rum kan tyckas ha ett kvadratiskt samband med pris, en modell där pris förklaras av antal rum och antal rum i kvadrat har följande utseende:

y=β0 + β3·x3 + β5·x32 + ε

21

Multipel linjär regressionExempel kvadratiska och kubiska termer

13121110 9 8 7 6 5 4 3

300000

200000

100000

Rooms

Pri

ce

S = 33631.2 R-Sq = 35.6 % R-Sq(adj) = 34.7 %

- 1606.41 Rooms**2

Price = -45919.6 + 39679.9 Rooms

Regression Plot

22

Multipel linjär regressionExempel kvadratiska och kubiska termerRegression Analysis: Price versus Rooms; Rooms**2

The regression equation is

Price = - 45920 + 39680 Rooms - 1606 Rooms**2

Predictor Coef SE Coef T P

Constant -45920 38935 -1,18 0,240

Rooms 39680 10477 3,79 0,000

Rooms**2 -1606,4 698,8 -2,30 0,023

S = 33631,2 R-Sq = 35,6% R-Sq(adj) = 34,7%

Ingen praktisk tolkning av b2

Kan även användas kubiska termer

Originalvariabeln behålls alltid i modellen!

23

Multipel linjär regressionSamspelstermer (interaktionstermer) Det behöver inte vara ett kvadratiskt samband mellan den

oberoende variabeln och den förklarande variabeln

Det kan vara så att den förklarande variabeln samspelar med en annan förklarande variabel

Relationen mellan den oberoende variabeln och en förklarande variabel kan vara beroende på värdet på en annan förklarande variabel

Då bildar man en samspelsterm (interaktionsterm), vilket beskrivs i kommande exempel

24

Multipel linjär regressionExempel samspelstermer (interaktionstermer)

Vi bygger vidare på modellen där pris förklaras av area och antal rum

Antal rum i kvadrat och interaktionstermen läggs till i modellen:

y = β0 + β1·x1 + β3·x3 + β5·x32 + β6 ·x1·x3

+ ε

25

Multipel linjär regressionExempel samspelstermer (interaktionstermer)

Regression Analysis: Price versus Area; Rooms; Rooms**2

The regression equation is

Price = - 15812 + 49,3 Area + 22544 Rooms - 1529 Rooms**2

Predictor Coef SE Coef T P

Constant -15812 34481 -0,46 0,647

Area 49,326 7,379 6,68 0,000

Rooms 22544 9549 2,36 0,020

Rooms**2 -1529,1 613,6 -2,49 0,014

S = 29528,4 R-Sq = 50,7% R-Sq(adj) = 49,6%

Alla variabler signifikanta när vi anpassar med den kvadratiska termen

26

Multipel linjär regressionExempel samspelstermer (interaktionstermer)

Regression Analysis: Price versus Area; Rooms; Rooms**2; Area*Rooms

The regression equation is

Price = 862 + 163 Area - 9248 Rooms + 2161 Rooms**2 - 14,0 Area*Rooms

Predictor Coef SE Coef T P

Constant 862 34085 0,03 0,980

Area 162,78 39,23 4,15 0,000

Rooms -9248 14262 -0,65 0,518

Rooms**2 2161 1390 1,56 0,122

Area*Rooms -14,002 4,759 -2,94 0,004

S = 28783,4 R-Sq = 53,4% R-Sq(adj) = 52,2%

När vi anpassar en modell med både kvadrattermen och interaktionstermen blir bara interaktionstermen signifikant. Den har ”tagit över” kvadrattermens roll.

27

Multipel linjär regressionExempel samspelstermer (interaktionstermer)

Regression Analysis: Price versus Area; Rooms; Area*Rooms

The regression equation is

Price = - 28051 + 109 Area + 11862 Rooms - 7,32 Area*Rooms

Predictor Coef SE Coef T P

Constant -28051 28707 -0,98 0,330

Area 108,55 18,06 6,01 0,000

Rooms 11862 4401 2,70 0,008

Area*Rooms -7,321 2,058 -3,56 0,001

S = 28922,9 R-Sq = 52,7% R-Sq(adj) = 51,7%

Vid anpassning med interaktionstermen blir alla signifikanta och vi får en högre förklaringsgrad.

28

Multipel linjär regressionSe upp med!

Det kan vara lockande att ha så många variabler som möjligt i modellen för att förklara variansen i datamaterialet bra

Dock kan detta leda till överanpassning, det vill säga att modellen blir ”för bra” anpassad till datamaterialet och att prediktionerna då blir felaktiga

Hitta en balans mellan antalet variabler och förklaringsgrad