Regresi on multiple - Gabriel Montes

Transcript of Regresi on multiple - Gabriel Montes

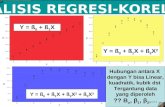

Regresion multiple

Regresion multiple

Gabriel V. Montes-Rojas

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Regresion multiple

Tomemos el ejemplo de retornos a la educacion en una ecuacion de Mincer. Como seimaginan, la educacion no es el unico determinante de los salarios. Otras variables quepueden afectar salarios son:

Edad

Experiencia

Habilidad (¿empresarial?)

Sexo (¿por?)

Raza/nacionalidad (¿por?)

Por ejemplo, un modelo mas cercano a la realidad es:

wage = β0 + β1educ + β2exper + u

¿Cambia la interpretacion de los coeficientes? Ahora β1 es el efecto de educ sobresalarios, manteniendo exper constante.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

En el modelo

wage = γ0 + γ1educ + e,

si omitimos exper , y si educ y exper estan relacionadas, o sea exper(educ), entonces,

γ1 =∂E [wage|educ ]

∂educ

=∂E [wage|educ, exper ]

∂educ+

∂E [wage|educ, exper ]

∂exper× ∂exper

∂educ

¿Cual es el problema? Si no controlamos por exper, estarıamos estimando un efectode educ que no es el que queremos. Es el problema de variables omitidas que veremosmas adelante. Aparece el problema de la causalidad.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

wage = β0 + β1educ + β2exper + u

β1 =∂E [wage|educ, exper ]

∂educ

Ahora β1 es el efecto de educ sobre wage, manteniendo exper constante. Incluyendoexper en el modelo, podemos medir el efecto de educ sin confundirlo con el efecto deexper.

Nota: En Economıa esto se usa mucho: ceteris paribus, dejando todo lo demasconstante.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Regresion multiple

y = β0 + β1x1 + β2x2 + ... + βK xK + u

Tenemos K + 1 variables explicativas, incluyendo una constante, es decir, siempre convalor 1.

En notacion matricial tenemos x = (1, x1, x2, ..., xK ) que es un vector 1× (K + 1) yβ = (β0, β1, ..., βK )

′ es un vector (K + 1)× 1, entonces

y = xβ + u

Entonces para cada observacion i tenemos

yi = x i β + ui

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Algebra de MCOEl estimador de MCO es

βMCO = argminb∈RK+1

N

∑i=1

(yi − b0 − b1x1i − ...− bK xKi )2

Para la minimizacion tomamos derivadas con respecto a b = (b0, b1, ..., bK ), lo cualnos da las siguientes condiciones de primer orden:

N

∑i=1

xji (yi − β0 − β1x1i − ...− βK xKi ) = 0, j = 0, 1, 2, ...,K .

Al igual que con la regresion simple podemos pensar la solucion como un metodo demomentos:

Momentos en la poblacionE [xju] = E [xj (y − β0 − β1x1 − ...− βK xK )] = 0

j = 0, 1, 2, ...,K(donde x0 = 1 es una constante)

Momentos en la muestra (CPO de la minimizacion)

N−1 ∑Ni=1 xji (yi − β0 − β1x1i − ...− βK xKi ) = 0

j = 0, 1, 2, ...,K

En ambos casos tenemos un sistema de ecuaciones con K + 1 ecuaciones y K + 1parametros.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Algebra de MCO

βMCO = (X ′X )−1X ′y

donde:

X es una matriz N × (K + 1), que contiene en cada una de las N filas laobservacion i y en cada una de las (K + 1) columnas los parametros.Nota: x0i = 1 para todo i = 1, 2, ...,N;

y es un vector N × 1, que contiene la variable dependiente;

... ası (X ′X ) es una matriz (K + 1)× (K + 1); ′ representa latranspuesta de una matriz;

... (X ′X )−1 es una matriz (K + 1)× (K + 1), la inversa de (X ′X );

... (X ′X )−1X ′y es un vector (K + 1)× 1.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Algebra de MCO

En detalle, las matrices y vectores son:

X =

1 x11 . . . xK1

1 x12 . . . xK2

......

......

1 x1N . . . xKN

, y =

y1

y2

...yN

, u =

u1

u2

...uN

, β =

β1

β2

...βK

,

X ′X =

N ∑N

i=1 x1i . . . ∑Ni=1 xKi

∑Ni=1 x1i ∑N

i=1 x21i . . . ∑N

i=1 x1ixKi...

......

...

∑Ni=1 xKi ∑N

i=1 xKix1i . . . ∑Ni=1 x

2Ki

, X ′y =

∑N

i=1 yi∑N

i=1 x1iyi...

∑Ni=1 xKiyi

.

La expresion para (X ′X )−1 requiere repasar como se calcula la inversa de una matriz.

MCO como ratio de sumatorias: Tambien se puede llegar a la siguiente expresion

muy util βMCO =(

∑Ni=1 x ′ix i

)−1 (∑N

i=1 x ′iyi)

.

Ejercicio: Resolver analıticamente para K = 1 (regresion simple) y K = 2 usandoalgebra matricial y luego resolviendo las condiciones de primer orden.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Algebra de MCO

βMCO = (X ′X )−1X ′y

Prueba: Planteemos el problema de minimizacion como

βMCO = argminb∈RK+1

u(b)′u(b) = argminb∈RK+1)

(y −Xb)′(y −Xb)

= argminb∈RK+1

[y ′y + b′X ′Xb− 2b′X ′y

].

Estamos definiendo u(b) ≡ y −Xb. Tenemos que tomar derivadas con respecto ab ∈ RK+1, un vector (K + 1)× 1. La solucion es un vector (K + 1)× 1 de condicionesde primer orden (hay reglas especıficas para derivar vectores y matrices). Entonces,2X ′Xb− 2X ′y = 0K+1, donde 0K+1 es un vector (K + 1)× 1 de ceros. Finalmente,X ′y = X ′Xb,⇒ βMCO = (X ′X )−1X ′y . Hay que chequear tambien las condiciones desegundo orden (para mınimo). Tomando la segunda derivada tenemos, 2X ′X que esuna matriz positiva semidefinida (chequear).

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Algebra de MCO

Otra forma de verlo es que las condiciones de momento se pueden expresar como:

X ′u(βMCO ) = X ′(y −X βMCO ) = 0K+1.

Entonces, X ′y = X ′X βMCO . Este es un sistema de ecuaciones lineales, nohomogeneo. Para que tenga solucion los coeficientes de las ecuaciones, dados porX ′X , no pueden ser linealmente dependientes. O sea el determinante no puede sercero. Entonces,

⇒ βMCO = (X ′X )−1X ′y .

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Supuesto 1: Lineal en parametros La variable dependiente y se relaciona con xpor una funcion lineal, y = β0 + β1x1 + ... + βK xK + u.

Supuesto 2: Muestreo aleatorio (yi , x1i , ..., xKi ), i = 1, 2, ...N es una muestraaleatoria del modelo del Supuesto 1.

Supuesto 3: Ausencia de colinealidad perfecta en X Para esto necesitamos que(X ′X ) sea no singular o rango(X ′X ) = K + 1 (notar que esto implica que(K + 1) ≤ N). Condicion necesaria y suficiente para esto es que no haya unarelacion lineal exacta entre los regresores (no confundir con multicolinealidad engeneral).

Supuesto 4: Media condicional cero E [u|x ] = 0.

MCO es insesgado E [βj |x ] = βj , j = 0, 1, 2, ...,K o E [β|x ] = β donde β es el vectorde todos los parametros.Prueba: E [βMCO |x ] = E [(X ′X )−1X ′y |x ] = E [(X ′X )−1X ′ (X β + u) |x ] =E [(X ′X )−1(X ′X )β|x ] + E [(X ′X )−1X ′u|x ] = β + (X ′X )−1X ′E [u|x ] = β. Especificardonde se usa cada supuesto explıcitamente.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Supuesto 5: Homocedasticidad Var [u|x ] = σ2IN

Teorema Gauss-Markov: Bajo los Supuestos 1-5, los estimadores MCO (β0, β1, ..., βK )son los mejores estimadores lineales insesgados (MELI) de (β0, β1, ..., βK ). Note:MEJOR significa mınima varianza dentro de la familia de estimadores linealesinsesgados. En ingles es BLUE, best linear unbiased estimator.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Varianza de MCO

En notacion matricial tenemos Var (β|x) = σ2(X ′X )−1

Prueba:Var (β|x) = Var [(X ′X )−1X ′y |x ] = (X ′X )−1X ′Var [y |x ]X (X ′X )−1 =(X ′X )−1X ′σ2X (X ′X )−1 = σ2(X ′X )−1X ′X (X ′X )−1 = σ2(X ′X )−1

Notar que Var (y |x) = Var (X β + u|x) = Var (y |x) = σ2IN por el supuesto de homocedasticidad. Definamos lamatriz N ×N de varianzas y covarianzas de los errores comoΩ = Var (u|x) = E [uu ′ |x ] + E [u|x ]E [u ′ |X ] = E [uu ′ |x ] (¿por que?).Ω juega un rol central para analizar la varianza. Con los supuestos de Gauss-Markov,

Ω = E [uu ′ |x ] = E

u2

1 u1u2 . . . u1uNu2u1 u2

2 . . . u2uN...

.

.

.. . .

.

.

.uNu1 uNu2 . . . u2

N

=

σ2 0 . . . 00 σ2 . . . 0

.

.

.

.

.

.. . .

.

.

.0 0 . . . σ2

= σ2IN .

En general, para los estimadores MCO podemos escribir la varianza como una forma sandwich,

Var (β|x) = Var ((X ′X )−1X ′u|x) = E [(X ′X )−1X ′uu ′X (X ′X )−1 |x ]

= (X ′X )−1E [X ′uu ′X |x ](X ′X )−1 = (X ′X )−1X ′Var (u|x)X (X ′X )−1

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-MarkovAhora podemos probar el Teorema de Gauss-Markov.Un estimador lineal requiere que sea una combinacion lineal de los elementos de y .Esta restriccion no es necesaria de acuerdo al nuevo paper de Hansen (2022). Sin embargo, todos los estimadores

que podemos derivar facilmente cumplen con esta propiedad y no nos estamos perdiendo nada.

Definamos C = (X ′X )−1X ′ +D donde D es una matriz no nula (K + 1)×N, noestocastica (puede depender de x). Ahora definamos β = Cy como otro estimador(no necesariamente MCO, pero lineal).

E [β|x ] = E [Cy |x ] = E [C (X β + u)|x ] = β + E [DX β|x ] + E [Cu|x ]

= (IK+1 +DX )β.

Para que sea insesgado debemos tener DX = 0(K+1)×(K+1). Notar que

E [Cu|x ] = 0K×1. Ahora calculemos la varianza, siempre condicional en x ,

Var [β|x ] = Var [Cy |x ] = CVar (y |X )C ′ = σ2CC ′ = σ2((X ′X )−1X ′+D)((X ′X )−1X ′+D)′

= σ2(X ′X )−1 + σ2DD ′ = Var [βMCO |x ] + σ2DD ′.

Dado que DD ′ es una matriz positiva semidefinida, tenemos el resultado:Var [β|x ]−Var [βMCO |x ] es una matriz positiva semidefinida.Notar que solo MCO no tiene forma sandwich: (X ′X )−1 ×ALGO × (X ′X )−1. Esto es un punto central paradetectar eficiencia.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Podemos plantear tambien una prueba constructiva. Ver Johnston y DiNardo (1996).

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Bruce Hansen (2022) “A Modern Gauss-Markov Theorem”:

“The development of least squares and the Gauss-Markov Theorem involved a seriesof contributions from some of the most influential probabilists of the nineteenth thruearly twentieth centuries. The method of least squares was introduced by AdrienMarie Legendre (1805) as essentially an algorithmic solution to the problem of fittingcoefficients when there are more equations than unknowns. This was quickly followedby Carl Friedrich Gauss (1809), who provided a probabilistic foundation. Gaussproposed that the equation errors be treated as random variables, and showed that iftheir density takes the form we now call “normal” or “Gaussian” then the maximumlikelihood estimator of the coefficient equals the least squares estimator. Shortlyafterward, Pierre Simon Laplace (1811) justified this choice of density function byshowing that his central limit theorem implied that linear estimators are approximatelynormally distributed in large samples, and that in this context the lowest varianceestimator is the least squares estimator. Gauss (1823) synthesized these results andshowed that the core result only relies on the first and second moments of theobservations and holds in finite samples. Andrei Andreevich Markov (1912) provided atextbook treatment of the theorem, and clarified the central role of unbiasedness,which Gauss had only assumed implicitly. Finally, Alexander Aitken (1935) generalizedthe theorem to cover the case of arbitrary but known covariance matrices. Thishistory, and other details, are documented in Plackett (1949) and Stigler (1986).”

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Teorema Gauss-Markov

Bruce Hansen (2022) “A Modern Gauss-Markov Theorem”: Un nuevo resultado en laeconometrıa determina que MCO no solo es MELI (BLUE), sino tambien MEI (BUE).Es decir, no es necesario que sea “lineal”.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Analisis de varianza

Definiciones...Suma de Cuadrados Totales (SCT): ∑N

i=1(yi − y )2

⇒ Variacion total en y ; Var (y ) = N−1 ∑Ni=1(yi − y )2

Suma de Cuadrados Explicados (SCE): ∑Ni=1(yi − y )2

⇒ Variacion en y explicada por el modelo

Suma de Cuadrados Residuales (SCR): ∑Ni=1(yi − yi )

2 = ∑Ni=1 u

2i

⇒ Variacion total en u

Se puede probar que: SCT=SCE+SCR

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

R2

Definicion: El R − cuadrado o R2 de una regresion es la fraccion de la variacion en yque es explicada por X , el modelo lineal propuesto.

R2 =∑N

i=1(yi − y )2

∑Ni=1(yi − y )2

= SCE/SCT = 1− SCR/SCT

0 ≤ R2 ≤ 1

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Precaucion

Cuantas mas variables explicativas se usan en el modelo, mayor va ser el R2. ¿Porque? Las X s ayudan a explicar la variacion en y siempre, aun cuando sean irrelevantes.

Nunca hay que juzgar un modelo en base al R2.

Los valores de R2 dependen del tipo de problema y de la experiencia...

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

R2 ajustado

Definicion: R2 o R2 ajustado es un estadıstico como el R2 pero donde se penaliza porla inclusion de variables.

R2 = 1− SCR/(N −K − 1)

SCT/(N − 1)

¡Ahora perdemos la interpretacion de 0 ≤ R2 ≤ 1!

Nota: R2 se incrementa solo si la variable adicional tiene un valor t mayor a uno envalor absoluto. Se puede usar como criterio de seleccion.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Varianza de MCO

Teorema: Bajo los Supuestos 1-5 de Gauss Markov,

Var (βj |x) =σ2

SCTj (1− R2j )

, j = 1, ...,K

donde SCTj = ∑Ni=1(xji − xj )

2 es la variacion total en xj y R2j es el R-cuadrado de una

regresion de xj en todas las otras variables (inluyendo el intercepto)1, x1, ..., xj−1, xj+1, ..., xK .

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Contrastes de hipotesis simples

Tomemos la hipotesis nula H0 : βj = βj0, j = 0, 1, ...,Kcontra la hipotesis alternativa HA : βj 6= βj0

(si H0 : βj = 0 es verdad entonces no hay relacion lineal entre y con xj , luego decontrolar por el efecto de las otras variables.)

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Contrastes de hipotesis simples

Bajo H0 : βj = βj0 y asumiendo que u ∼ Normal(0, σ2), tiene distribucionnormal estandar, tenemos que

(βj − βj0)/se(βj ) ∼ tN−K

donde se(.) es error estandar (raız cuadrada de la varianza) y tN−K−1 es unadistribucion t con grados de libertad N −K − 1.

¿De donde viene N −K − 1? De que tenemos N observaciones y estimamosK + 1 parametros. La variable aleatoria t − Student tiene colas mas anchascuanto menos grados de libertad tiene. Por otro lado cuando los grados delibertad tienden a infinito, la distribucion t se vuelve igual a la normal/gaussiana.

Para obtener Var (β|X ) necesitamos un estimador de σ2, la varianza del error, lacual tambien necesita ser estimada.

σ2 =∑N

i=1 u2i

N −K − 1

Se puede probar que E (σ2|x) = σ2.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Contrastes de hipotesis multiples

Se pueden contrastar hipotesis como H0 : β1 = 0, β2 = 0,

o como H0 : β1 = β2.

Estas hipotesis se contrastan con test F.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Contrastes de hipotesis multiples

En general, si tenemos un modelo con K variables independientes (mas unaconstante), pero queremos testear por Q restricciones lineales (no perfectamentecolineales entre sı), se defineur (unrestricted model) modelo sin restricciones (K variables)r (restricted model) modelo con las restricciones (el modelo estimado satisfaciendotodas las Q restricciones)Entonces:

F =(R2

ur − R2r )/Q

(1− R2ur )/(N −K − 1)

∼ F (Q,N −K − 1)

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Contraste para la significancia del modelo

Supongamos que nos interesa: H0 : β1 = ... = βK = 0En este caso Q = K , el numero de restricciones es igual al numero de variablesexplicativas (excepto la constante).Entonces el estadıstico F es:

F =R2/K

(1− R2)/(N −K − 1)∼ F (K ,N −K − 1)

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Ejemplo: Efecto de fumar sobre el peso de los reciennacidos

Consideremos la siguiente regresion:

bwght = β0 + β1cigs+ β2parity+ β3faminc

+β4motheduc+ β5fatheduc+ u

dondebwght: birth weight, in pounds;cigs: average number of cigarettes the mother smoked per day during pregnancy;parity: birth order of the child;faminc: annual family income;motheduc: years of schooling of the mother;fatheduc: years of schooling of the father.

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Ejemplo: Efecto de fumar sobre el peso de los reciennacidos

use http://fmwww.bc.edu/ec-p/data/wooldridge/bwght, clear

reg bwght cigs parity faminc motheduc fatheduc

STATAbwght Coef. Std. Err. t P > |t|cigs -.5959362 .1103479 -5.401 0.000

parity 1.787603 .6594055 2.711 0.007faminc .0560414 .0365616 1.533 0.126

motheduc -.3704503 .3198551 -1.158 0.247fatheduc .4723944 .2826433 1.671 0.095

cons 114.5243 3.728453 30.716 0.000

http://fmwww.bc.edu/gstat/examples/wooldridge/wooldridge4.html

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Ejemplo: Efecto de fumar sobre el peso de los reciennacidos

Si quisieramos hacer un contraste de H0 : β4 = 0, β5 = 0

test motheduc fatheduc

(1) motheduc = 0.0(2) fatheduc = 0.0

F( 2, 1185) = 1.44Prob > F = 0.2380

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Ejemplo: Efecto de fumar sobre el peso de los reciennacidos

El estadıstico F se puede construir a mano:

reg bwght cigs parity faminc motheduc fatheduc

scalar R2ur=e(r2) (guarda R2ur )

reg bwght cigs parity faminc if fatheduc∼=.scalar R2r=e(r2) (guarda R2

r )

F =(R2

ur − R2r )/Q

(1− R2ur )/(N −K − 1)

∼ F (Q,N −K − 1)

scalar F=(R2ur-R2r)/2/(1-R2ur)*(e(N)-5-1) (estadıstico F)scalar pvalueF=Ftail(2,e(N)-5-1,F)(obtiene el p-valor)display "F statistic : " F

display "p-value : " pvalueF

Gabriel Montes-Rojas Regresion multiple

Regresion multipleEstimacionTeorema Gauss-MarkovInferencia

Ejemplo: Efecto de fumar sobre el peso de los reciennacidos

Supongamos que queremos testear la siguiente hipotesis: H0 : β4 = β5

test motheduc=fatheduc

...

reg bwght cigs parity faminc motheduc fatheduc

scalar R2ur=e(r2) (guarda R2ur )

gen mfeduc=matheduc+fatheduc

reg bwght cigs parity faminc mfeduc

scalar R2r=e(r2) (guarda R2r )

scalar F=(R2ur-R2r)/1/(1-R2ur)∗(e(N)-5-1) (estadıstico F)

scalar pvalueF=Ftail(2,e(N)-5-1,F)(obtiene el p-valor)display "F statistic : " F

display "p-value : " pvalueF

Gabriel Montes-Rojas Regresion multiple